با نحوه استفاده از Ollama در ویندوز ۱۱ همراه باشید. با Olama، می توانید LLM ها را به راحتی در دستگاهتان اجرا کنید.

اگر می خواهید مدل های زبان بزرگ یا LLM را اجرا کنید، یکی از سادهترین راه ها برای انجام این کار از طریق Ollama است. Ollama یک پلتفرم منبع باز قدرتمند است که یک تجربه هوش مصنوعی قابل تنظیم و به راحتی قابل دسترسی را ارائه می دهد. بدون نیاز به تکیه بر پلتفرم های مبتنی بر ابر یا نیاز به تخصص فنی، دانلود، نصب، و تعامل با LLM های مختلف را آسان می کند.

علاوه بر این مزایا، Ollama بسیار سبک وزن است و به طور منظم به روز می شود، که آن را برای ساخت و مدیریت LLM در ماشین های محلی کاملا مناسب می کند. بنابراین، شما به هیچ سرور خارجی یا تنظیمات پیچیده ای نیاز ندارید. Ollama همچنین از چندین سیستم عامل از جمله ویندوز، لینوکس و macOS و همچنین محیط های مختلف Docker پشتیبانی می کند. برای یادگیری نحوه استفاده از Ollama برای اجرای LLM در دستگاه ویندوز نحوه استفاده از Ollama در ویندوز ۱۱ را ببینید.

دانلود و نصب Ollama

را در مراحل زیر می بینید.

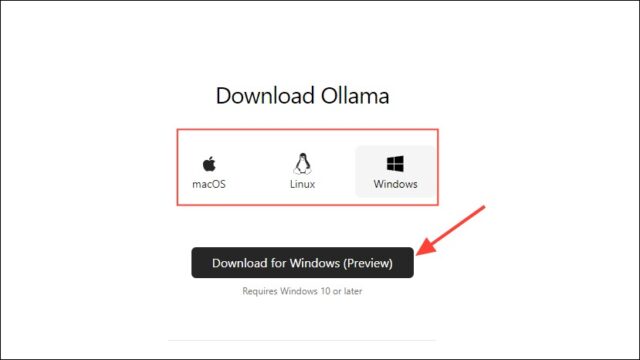

۱- ابتدا وارد صفحه دانلود و نصب Ollama شوید و قبل از کلیک بر روی دکمه Download سیستم عاملتان را انتخاب کنید. همچنین، می توانید Olama را از صفحه GitHub آن دانلود کنید.

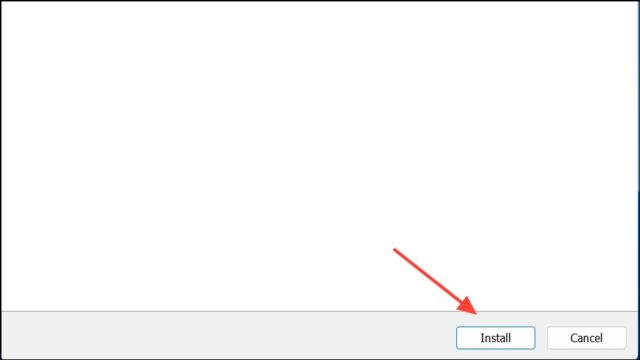

۲- پس از اتمام دانلود، آن را باز کنید و روی دستگاه نصب کنید. پس از اتمام نصب، نصب کننده به طور خودکار بسته می شود.

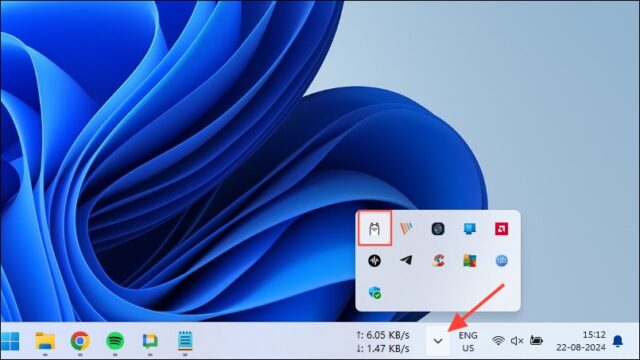

۳- در ویندوز، با کلیک بر روی دکمه سرریز نوار وظیفه برای مشاهده آیکون های مخفی، می توانید بررسی کنید که Ollama در حال اجرا است یا خیر.

نحوه استفاده از Ollama در ویندوز ۱۱

هنگامی که Olama روی دستگاه شما نصب شد، اولین کاری که باید انجام دهید این است که محل ذخیره داده ها را تغییر دهید. به طور پیش فرض، مکان ذخیرهسازی C:Users%username%.ollamamodels است، اما از آنجایی که مدل های هوش مصنوعی می توانند بسیار بزرگ باشند، درایو C شما می تواند به سرعت پر شود. برای انجام این کار،

۱- ابتدا بر روی آیکون Ollama در تسک بار کلیک کنید و روی ‘Quit Ollama’ کلیک کنید.

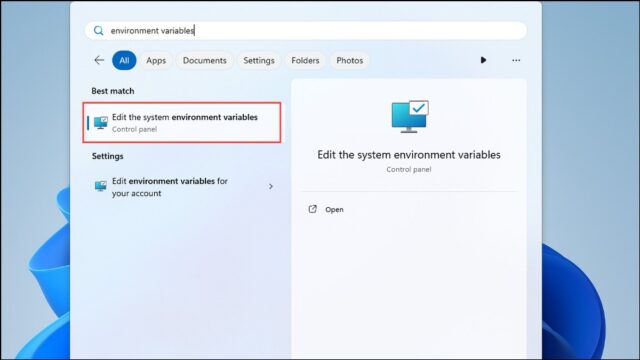

۲- وقتی از Ollama خارج شدید، منوی استارت را باز کنید، متغیرهای محیطی را تایپ کنید و روی Edit the system environment variables کلیک کنید.

۳- وقتی دیالوگ باکس System Variables ظاهر شد، روی گزینه Environment Variables در زبانه Advanced کلیک کنید.

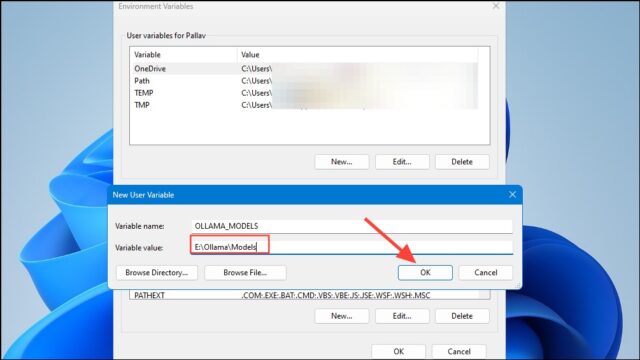

۴- روی دکمه New برای حساب کاربری کلیک کنید و یک متغیر به نام OLLAMA_MODELS در قسمت Variable name ایجاد کنید.

۵- سپس مکان دایرکتوری را که می خواهید Ollama مدل هایتان را در قسمت ‘Variable value’ ذخیره کند، تایپ کنید. سپس پیش از راهاندازی Ollama از منوی Start، روی دکمه ‘OK’ کلیک کنید.

نکته: شما همچنین می توانید سایر متغیرهای سیستم را برای Ollama تنظیم کنید، مانند ‘Ollama_Host’، ‘Ollama_Port’، ‘Ollama_Origins’، ‘Ollama_Debug’، و موارد دیگر. قبل از استفاده از این متغیرها، حتما اسناد را بررسی کنید.

۶- اکنون شما آماده شروع استفاده از Ollama هستید و می توانید این کار را با Llama 3 8B متا، آخرین مدل AI منبع باز این شرکت انجام دهید. برای اجرای مدل، یک پنجره فرمان، Powershell یا Windows Terminal را از منوی Start اجرا کنید.

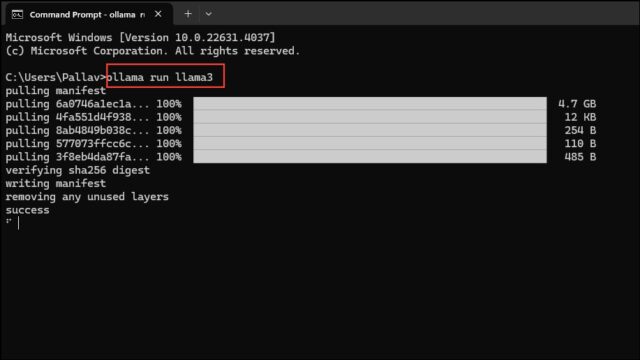

۷- هنگامی که پنجره خط فرمان باز شد، ollama run llama3 را تایپ کنید و Enter را فشار دهید. مدل نزدیک به ۵ گیگابایت است، بنابراین دانلود آن زمان می برد.

۸- پس از تکمیل دانلود، می توانید از Llama 3 8B استفاده کنید و مستقیم در پنجره خط فرمان با آن مکالمه کنید. به عنوان مثال، می توانید از مدل بپرسید Who are you؟ و برای دریافت پاسخ Enter را فشار دهید.

۹- اکنون می توانید مکالمه را ادامه دهید و از مدل های AI در موضوعات مختلف سؤال کنید. فقط به خاطر داشته باشید که Llama 3 می تواند اشتباه و توهم کند ، بنابراین باید هنگام استفاده از آن مراقب باشید.

۱۰- همچنین می توانید با مراجعه به صفحه کتابخانه مدل Ollama ، مدل های دیگری را امتحان کنید. علاوه بر این، دستورهای مختلفی وجود دارد که می توانید اجرا کنید تا عملکردهای مختلفی را که Ollama ارائه می دهد، امتحان کنید.

۱۱- شما می توانید هنگام اجرای یک مدل، مانند تنظیم متغیرهای جلسه، نشان دادن اطلاعات مدل، صرفه جویی در جلسه و موارد دیگر، عملیات مختلفی را انجام دهید.

۱۲- Ollama همچنین به شما امکان می دهد تا از مدل های AI Multimodal استفاده کنید تا تصاویر را تشخیص دهید. به عنوان مثال ، مدل LLAVA می تواند تصاویر تولید شده توسط Dalle-3 را تشخیص دهد. این می تواند تصاویر را با جزئیات توصیف کند.

۱۳- اگر هنگام اجرای Ollama به خطا برمی خورید، می توانید لیست ها را بررسی کنید تا بدانید مسئله چیست. برای باز کردن گفتگوی Run از میانبر Win + R استفاده کنید و سپس Explorer ٪ LocalAppData ٪ ollama # مشاهده را قبل از فشار دادن وارد کنید.

۱۴- همچنین می توانید از دستورهای دیگری مانند اکسپلورر %LOCALAPPDATA%ProgramsOllama و کاوشگر %HOMEPATH%.ollama برای بررسی باینری ها، مدل و مکان ذخیرهسازی پیکربندی استفاده کنید.

نکته: مدل های کوچکتر هوش مصنوعی مانند Llama 3 8B می توانند روی دستگاه شما اجرا شوند اگر فقط گرافیک یکپارچه داشته باشد. با این حال، اگر یک پردازنده گرافیکی اختصاصی انویدیا دارید، می توانید مدل های بزرگتر را با نصب جعبه ابزار CUDA اجرا کنید. همه پردازنده های گرافیکی AMD نمی توانند مدلهای هوش مصنوعی را اجرا کنند، اما آنهایی که می توانند به جعبه ابزار نیازی ندارند.

Ollama به طور خودکار GPU شما را برای اجرای مدلهای AI شناسایی می کند، اما در ماشین هایی با چندین پردازنده گرافیکی، می تواند یک اشتباه را انتخاب کند. برای جلوگیری از این امر، کنترل پنل انویدیا را باز کنید و صفحه نمایش را روی Nvidia GPU Only تنظیم کنید.

Display Mode ممکن است در هر دستگاهی موجود نباشد و همچنین هنگامی که دستگاه را به نمایشگرهای خارجی وصل می کنید وجود ندارد.

در ویندوز، می توانید بررسی کنید که Olama از GPU درستی با استفاده از Task Manager استفاده می کند که استفاده از GPU را نشان می دهد و به شما اطلاع می دهد که از کدام یک استفاده می شود.

در حالی که نصب Ollama روی macOS و Linux کمی با ویندوز متفاوت است، روند اجرای LLM از طریق آن کاملا مشابه است.

نحوه استفاده از Ollama در ویندوز ۱۱ به این ترتیب است.