حتماً قبل از استفاده از یک ربات چت هوش مصنوعی برای دریافت خلاصهای سریع از اخبار، باید دو بار فکر کنید. گزارشی جدید از بیبیسی نشان میدهد که رباتهای چت محبوب نتایج خلاصهای با اشتباهات عمده تولید میکنند.

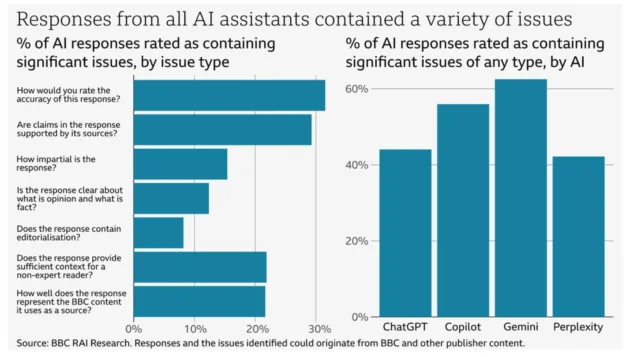

Google Gemini بالاترین درصد از خلاصههای مشکلدار را داشت

آزمایش شامل ChatGPT، Google Gemini، Microsoft Copilot و Perplexity AI بود. ابتدا، بیبیسی از هر ربات چت ۱۰۰ سوال در مورد اخبار پرسید و خواست که در صورت امکان از منابع اخبار بیبیسی استفاده کنند.

سپس کارشناسان بیبیسی کیفیت این خلاصهها را ارزیابی کردند. از میان این خلاصهها، ۵۱ درصد دارای نوعی خطا بودند، از جمله نادرستیهای واقعی، نقلقولهای اشتباه یا اطلاعات قدیمی.

از این تعداد، ۱۹ درصد شامل اشتباهات واقعی مانند تاریخ نادرست بودند. همچنین، ۱۳ درصد از نقلقولهایی که به بیبیسی نسبت داده شده بود، یا تغییر یافته بودند یا اصلاً در مقالاتی که به رباتهای چت ارائه شده بود، وجود نداشتند.

در بررسی عملکرد هر ربات، گوگل جمنای بدترین عملکرد را داشت، به طوری که بیش از ۶۰ درصد از خلاصههای آن شامل اطلاعات مشکلدار بودند. پس از آن، مایکروسافت کوپایلوت با ۵۰ درصد و سپس ChatGPT و Perplexity با حدود ۴۰ درصد پاسخهای دارای خطا قرار گرفتند.

در نتیجهگیری این مطالعه، بیبیسی بیان کرد که بسیاری از این مشکلات فراتر از صرفاً اطلاعات نادرست بودند:

این تحقیق همچنین نشان میدهد که دامنه خطاهای ایجادشده توسط دستیارهای هوش مصنوعی فراتر از صرفاً نادرستیهای واقعی است. دستیارهای هوش مصنوعی که مورد آزمایش قرار گرفتند، در تشخیص تفاوت بین نظر و واقعیت دچار مشکل شدند، در برخی موارد متون را با دیدگاههای شخصی بازنویسی کردند و اغلب از ارائهی زمینهی ضروری بازماندند. حتی زمانی که هر جمله در یک پاسخ دقیق باشد، این نوع مشکلات میتوانند منجر به پاسخهای گمراهکننده یا جانبدارانه شوند.

نتایج این مطالعه همچنان شگفتانگیز است، زیرا تعداد بالایی از پاسخها دارای اشکالاتی بودند. هوش مصنوعی هنوز راه درازی در پیش دارد تا به ابزاری مطمئن برای دریافت اخبار تبدیل شود.

قابلیتهای هوش مصنوعی هنوز در حال تکامل هستند

فناوری هوش مصنوعی، بهویژه چتباتها، بهسرعت در حال پیشرفت است. اما همانطور که مطالعهی بیبیسی نشان میدهد، انتظار دریافت اطلاعات دقیق دربارهی اخبار همچنان یک چالش بزرگ محسوب میشود.

بیبیسی پیشتر نیز نسبت به یکی دیگر از قابلیتهای مبتنی بر هوش مصنوعی اعتراض کرده بود: خلاصههای اعلانیههای Apple Intelligence. در دسامبر ۲۰۲۴، یک خلاصهی خبری نادرست اعلام کرد که لویجی مانیونه به خودش شلیک کرده است، در حالی که او مظنون به تیراندازی به برایان تامپسون، مدیرعامل یک شرکت مراقبتهای بهداشتی، بود.

در پاسخ به اعتراض بیبیسی و دیگر شکایات، اپل بهطور موقت خلاصههای خبری و محتوای سرگرمی را در iOS 18.3 غیرفعال کرد.

بنابراین، اگر میخواهید از اخبار مطلع شوید، روش سادهتر و مطمئنتر این است: به جای خلاصهی هوش مصنوعی، خودتان خبر را بخوانید.